Virgen de Loreto

Este espacio está reservado para los artículos ya publicados

Articulo Diciembre 2008 UNA TÉCNICA PARA ELABORAR ESCALAS DE ACTITUDES (II)

TÉCNICAS DE INFORMES SOBRE SI MISMO

El diferencial semántico no se concibió originalmente para

medir actitudes. El propósito inicial de Osgoad y colaboradores se encaminó hacia la exploración de las dimensiones del significado. Este esfuerzo fue

alentado por el rápido perfeccionamiento de las computadoras que pronto se convirtieron en invaluable ayuda para los tediosos cálculos del análisis

factorial. Que ha dado lugar al nuevo enfoque, en la semántica experimental, en la medición de actitudes.

El diferencia¡ semántico no mide las reacciones de los individuos a objetos semánticos. Esto se consigue por estimaciones del objeto

sobre varias escalas sencillas de estimación, definidas por adjetivos bipolares; por ejemplo Bueno-Malo, Bonito-Feo, Caliente-Frio. Las estimaciones de cada

objeto se correlacionan y analizan factorialmente para determinar las dimensiones del significado.

Numerosas repeticiones dé éste procedimiento han

contribuido a demostrar la estabilidad de las tres dimensiones siguientes: la evaluativa; la de potencia y la de actividad. Teniendo en cuenta que la

actitud comprende claramente una respuesta evaluativa con respecto a un objeto de actitud, la aplicación del diferencial semántico a la medición de actitudes se ha iniciado con gran entusiasmo. Osgood, Tanenbaum y Suci,

en su libro "La medición del significado", definen su posición con respecto a la adaptación del diferencial semántico a la medición de actitudes.

Desde sus comienzos, el diferencial semántico ha cobrado extraordinaria popularidad entre

los investigadores de la rama. Por ello no deja de causar cierta sorpresa el hecho de que nadie, hasta ahora, haya resumido y examinado

críticamente su uso como método de medición de actitudes. A petición del director, David R. Heise escribió la revisión crítica. Esta es la única revisión completa de que se dispone hasta la fecha

y, por lo mismo será especialmente útil para quienes se interesen por la aplicación del tan citado diferencial semántico.

¿Cómo se sabe si los reactivos seleccionados para una medición de actitudes

basada en informes acerca de sí mismo reflejan la actitud que se supone están explorando? O, más sencillamente, ¿cómo puede establecerse si todos esos

reactivos captan la misma dimensión de actitud, cualquiera que sea? La validez de contenido, o lógica, de los reactivos de una escala de reactivos múltiples se

hace generalmente sobre una base a priori y a primera vista. Mas adelante

veremos dos métodos para establecer definiciones operacionales válidas de escalas de reactivos múltiples. Kerlinger y Kaya demuestran la utilidad del

análisis factorial para probar la monodimensionalidad de los reactivos que se tenga planeado incluir en una escala. Lingoes da a conocer un procedimiento de

computación para seleccionar grupos de reactivos monodimensionales a partir de una serie de reactivos dicotómicos que pueden tratarse posteriormente como una

escala de Guttman. Tradicionalmente, la medición de actitudes ha significado ubicar individuos a lo

largo de un continuo único de actitud, generalmente sobre una dimensión evaluativa. De ahí los grandes esfuerzos que se han dedicado al desarrollo de

escalas monodimensionales. Ha sido costumbre pensar que las personas son más o menos favorables, pro o anti, positivas o negativas, hacia determinado objeto de

actitud. Recientemente la atención se ha dirigido al estudio de

cómo ubicar los objetos en un espacio multidimensional. Esta via es prometedora, si bien sus progresos han sido lentos tal vez por la preparación

técnica que se requiere para ingresar al campo de la elaboración de escalas multidimensionales.

John Ross ha preparado una introducción, tan admirable como

técnicamente exacta, a la elaboración de escalas multidimensionales. Naturalmente que tal clase de escalas no tiene por qué limitarse a los

datos de informes sobre sí mismo. Como eñala Ross, puede esclarecer los aspectos teóricos de la actitud a la vez que mejorar la medición de actitudes.

Otra de las contribuciones recientes, digna de tenerse en cuenta dentro de la

medición de actitudes, es el "Enfoque de juicio social - implicación", de Sherif y Sherif, que se basa en los hallazgos del estudio experimental

del juicio -psicofísico y social- y en los de compromiso del si-mismo o del yo. Este enfoque permite tanto una estructura teórica de las actitudes, basada

sólidamente en investigaciones experimentales, como una técnica interesante de medición. Y como tal merece atenta consideración por parte de los investigadores

de actitudes. MEDICIÓN DE ACTITUDES

Uno de los resultados secundarios pero importantes de la investigación en semántica experimental, es un nuevo enfoque y fundamento de la medición

de actitudes. Ha sido posible identificar la "actitud" como una de las dimensiones importantes del significado general y con ello extender los

procedimientos de medición del diferencial semántico a uno de los campos primarios de la psicología social.

Al trabajar en este campo con el mencionado diferencial se han encontrado evidencias de un principio general que gobierna

algunos aspectos del proceso cognoscitivo o sea un principio de congruencia. Aunque la operación de este principio no se limita necesariamente a la dimensión actitudinal del espacio del significado,

se encuentra primeramente relacionado con la investigación sobre medición de actitudes y, por consiguiente, se usa dentro de este contexto.

Una definición de actitud

A pesar de la gran cantidad de definiciones de "actitud" en la ciencia social

contemporánea, es evidente cierto consenso y acuerdo, particularmente en lo que se refiere a las propiedades principales de aquéllas. La mayoría de las

autoridades en la materia están de acuerdo en que las actitudes se aprenden y permanecen implícitas; son estados inferidos del organismo que, al parecer, se

adquieren de manera muy semejante a como lo hacen otras actividades internas aprendidas. Son, al mismo tiempo, predisposiciones a responder; pero se

distinguen de otros estados similares en que predisponen a una respuesta evaluativa.

Por tanto, las actitudes se describen como "tendencias de acercamiento o evitación", o como "favorables o desfavorables", y así

sucesivamente. Esta noción se relaciona con otra opinión compartida: que las actitudes pueden adscribirse a un continuo básico bipolar, con un punto de

referencia neutral o cero, lo que implica que tienen dirección e intensidad y a la vez proporcionan una base para obtener índices cuantitativos de ellas. Para usar una nomenclatura diferente, las actitudes son procesos implícitos

que tienen propiedades recíprocamente antagónicas y que varían de intensidad.

Esta caracterización de la actitud como un proceso aprendido implícito, que es potencialmente bipolar, varía en su intensidad y media la conducta evaluativa,

sugiere que la actitud es parte para algunos especialistas, la parte principal de la actividad interna de mediación que opera entre la mayoría de las

estructuras de estímulo y de respuesta. Esta identificación de la actitud con la actividad mediatoria, ha sido hecha más explícita por Doob (1947), quien al

situarla dentro de la estructura de la teoría hulliana de la conducta, la identificó con el "acto puro de estímulo" en tanto que mecanismo mediador.

Sin embargo, aunque deficiente, es esta una identificación y localización de la actitud en sí, dentro de este sistema general de actividad de mediación. Nuestro

trabajo en la medición semántica parece sugerir tal identificación: si la actitud consiste en una porción de la actividad interna de mediación es,

entonces, por inferencia de nuestro modelo teórico, parte de la estructura semántica de un individuo y puede indicarse en correspondencia. Luego, el

análisis factorial del significado puede suministrar la base para extraer este componente actitudinal del significado.

En todos los análisis factoriales realizados hasta la fecha; ha aparecido invariablemente un factor de naturaleza evaluativa fácilmente

identificable; por lo común, ha sido el factor dominante, que explica la mayor proporción de la varianza total. A pesar de los diferentes conceptos y criterios

para seleccionar las escalas se obtuvieron consecuentemente valores altos y restrictivos en relación a este factor y con respecto a escalas como bueno-malo,

justo-injusto y valioso-inútil, mientras que escalas que eran intuitivamente de naturaleza no evaluativa, como rápido-lento, estable-mudable y pesado-ligero,

por lo común tuvieron valores pequeños o despreciables con respecto a este factor. Parece razonable identificar la actitud, como se concibe generalmente en

el lenguaje común y corriente y en el científico, con la dimensión evaluativa del espacio semántico total, según se la aísla en la factorialización de juicios

significativos. Fundados en las operaciones de medida con el diferencial semántico, se ha

definido el significado de un concepto como su ubicación en un punto del espacio semántico multidimensional. Seguidamente, se define la actitud hacia un concepto

como la proyección de aquel punto sobre la dimensión evaluativa de dicho espacio. Obviamente, cada punto del espacio semántico tiene un componente

evaluativo (aunque el componente puede tener magnitud cero, cuando los juicios evaluativos son neutrales) y, por consiguiente, cada concepto debe tener un

componente actitudinal como parte de su significado total. Esto no implica que

la dimensión evaluativa o actitudinal sea inevitablemente estable en orientación con respecto a otras dimensiones del espacio; según sea el concepto o

conjunto de conceptos que se juzguen, pueden hacerse rotar escalas "puramente" evaluativos, como bueno-malo, de manera que queden alineadas con el factor de

potencia, el factor de "adiencia sensorial",, factor que dispone al organismo a la acción continua de un estímulo y así sucesivamente. En otras palabras, el tipo

de evaluación puede cambiar con el marco de referencia determinado por los conceptos (por ejemplo, político, estético, etc.).

Procedimiento de medición con el diferencial semántico

Conforme a la definición y fundamento dados anteriormente para medir la actitud, se usarían grupos de escalas con valores altos del factor evaluativo a través de

conceptos con valores despreciables de otros factores, según lo determinaran nuestros diferentes estudios de análisis factorial. Así, se usarían escalas como

bueno-malo, optimista-pesimista y positivo-negativo y no escalas como tierno-cruel, fuerte-débil o bello-feo, porque éstas resultarían generalmente

menos evaluativas a medida que se hace variar el concepto que se juzga. Sin

embargo, dado que el trabajo de factorialización de concepto a concepto en que se basan los principios presentes no se realizó en el momento en que se

emprendieron la mayoría de las medidas de actitud no siempre se cumplieron este criterio ideal. Para propósitos de consistencia de

calificación, se asignan uniformemente a los polos desfavorables de nuestras escalas evaluativas (por ejemplo, molo, injusto, insignificante, etc.) la

puntuación "1 " y a los polos favorables (bueno, justo, valioso) la puntuación "7", esto independientemente de la presentación de las escalas a los sujetos en

el diferencial gráfico, donde deben distribuirse aleatoriamente respecto a la dirección.

A continuación se suman simplemente todas las estimaciones evaluativas para obtener la "puntuación" de actitud. Un método más afinado sería valorar cada

escala con base en su carga de factor evaluativo con respecto a los conceptos que se juzgan; pero esto sería sumamente laborioso y, si las escalas son

"puramente" evaluativas, como se definieron arriba, es seguro que se mejoraría muy poco la precisión del instrumento. También debe señalarse que en la práctica

incluimos por lo común un número considerable de escalas que representan otros factores; se hace esto tanto para oscurecer el propósito de la medición como

para proporcionar información adicional sobre el significado del concepto como un todo, además de la actitud hacia él.

Las propiedades principales de la actitud que se espera indique cualquier técnica de medición se estudian cómodamente por este procedimiento. La dirección

de la actitud favorable o desfavorable, queda indicada sencillamente en términos bipolares; si la puntuación cae más cerca de los polos favorables, entonces se

considera favorable la actitud, y viceversa. Una puntuación que cae en el origen, definido por el "4" de las escalas, se considera un índice de

neutralidad de la actitud. La intensidad de la actitud se indica por la distancia al origen de la puntuación sobre la dimensión evaluativa; es decir,

por la polarización de la puntuación de actitud. Aunque en una escala existen

solamente tres niveles de intensidad, "ligeramente", "bastante", y "extremadamente", en cualquier dirección, la suma en varias escalas evaluativas

produce grados más afinados de intensidad. Por ejemplo, si se usan seis escalas tenemos una amplitud de puntuaciones posibles desde seis (la más desfavorable),

pasando por 24 (exactamente neutral) hasta 42 (la más favorable), aparte de 18 grados de intensidad de puntuación de actitud en cada dirección. Con base en un

trabajo anterior Katz, y Cantril, se supuso que una puntuación neutral es de intensidad mínima en cuanto a actitud. La monodimensionalidad de

la escala de actitud resulta automáticamente de los procedimientos analítico factoriales a partir de los cuales se seleccionan las escalas.

Si las escalas usadas se seleccionan teniendo en cuenta que todas tienen valores puros y altos

del mismo factor -idealmente mantienen esta consistencia a través de varios análisis factoriales- debe lograrse monodimensionalidad. En otras palabras, el

análisis factorial es, en sí mismo, un método para probar la monodimensionalidad de los reactivos o escalas que forman un test.

Evaluación del diferencial como medida de actitud

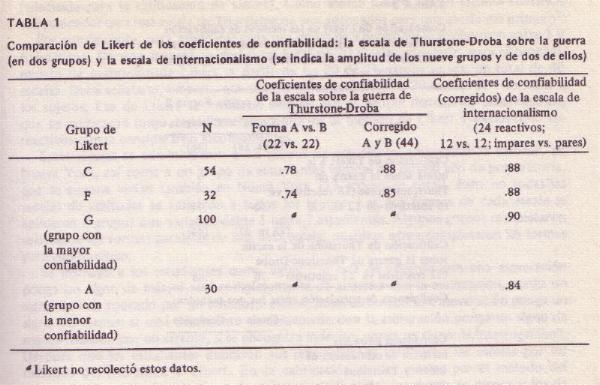

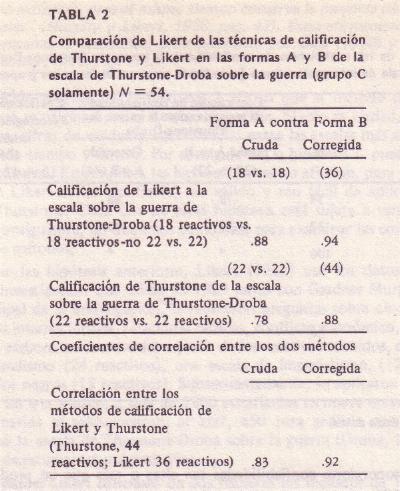

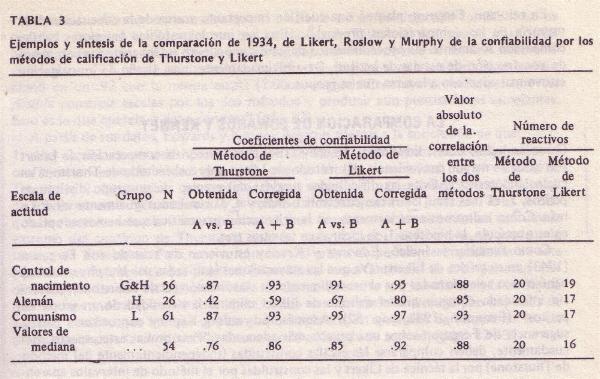

Confiabilidad. Tannenbaum (1953) obtuvo datos de confiabilidad test-retest.

Empleando seis conceptos (Lideres sindicales, "The Chicago Tribune", Senador Robert Taft, Apuestas legalizadas, Arte abstracto y Programas universitarios acelerados)

fueron juzgados en relación a seis escalas evaluativas (bueno-malo, justo-injusto, valioso-insignificante, sabroso-desagradable, limpio sucio y

placentero-molesto) por 135 sujetos en dos ocasiones separadas entre sí por cinco semanas.

Se computaron puntuaciones de actitud sumando las seis escalas, después de realinearlas de acuerdo con una dirección evaluativa constante. Los

coeficientes de test-retest variaron desde .87 a .93, con una r media (computada por medio de la transformación z) de .91. En otro estudio, se obtuvieron datos

adicionales de confiabilidad, que confirman estos; aparecen en la tabla 1. Validez. La dimensión evaluativa del diferencial semántico muestra una validez

bastante razonable como medida de actitud. Por ejemplo, Suci (1952) pudo diferenciar entre etnocéntricos altos y bajos, determinados independientemente a

partir de la escala E de los estudios de personalidad autoritaria, con base en sus estimaciones de varios grupos étnicos en las escalas evaluativas del

diferencial. Similarmente, se encontró que las estimaciones de las escalas

evaluativas discriminan en las formas esperadas entre matices de preferencia política, en un estudio de Suci de la conducta del votante y en un estudio de

simbolismo pictórico político de Tannenbaum y Kerrick. Sin embargo, a diferencia

de la medida del significado en general, en el caso de la actitud tenemos otros instrumentos de medida desarrollados independientemente y con respecto a los

cuales se puede evaluar esta técnica. Veamos dos de estas comparaciones;

la primera, con las escalas de Thurstone; y la segunda, con una escala del tipo de Guttman.

Comparación con los escalas de Thurstone. Se evaluaron tres conceptos (Los

Negros, La Iglesia y La pena capital) con respecto a una serie de escalas, que incluían cinco puramente evaluativas (justo-injusto, valioso-insignificante, placenter-omolesto, limpio- sucio y bueno-malo). Además, los sujetos indicaron sus

actitudes en escalas de Thurstone diseñadas especialmente para medir estos objetos de actitud ; la escala estándar para la iglesia, la forma B de la escala

de los negros y la forma A de la escala de la pena capital de Thurstone. Los sujetos fueron divididos en dos grupos antes de someterlos a las

pruebas: a uno de los grupos (N=23) se le dio primero la forma del diferencial semántico; y una hora después los tests de Thurstone. El otro grupo (N=27)

recibió las mismas pruebas pero en orden contrario. Dos semanas después de esta sesión inicial, a los sujetos se les aplicaron nuevamente ambos tests, pero en

esta ocasión se invirtieron los órdenes respectivos. La segunda sesión se llevó a cabo para obtener información de confiabilidad sobre ambos tipos de

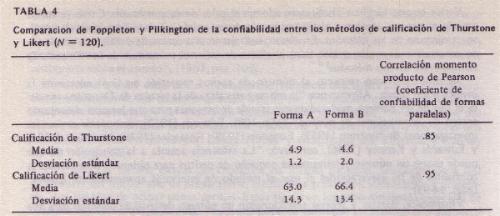

instrumentos de medición de las actitudes. Las columnas (1) y (2) de la tabla 1

muestran las correlaciones momento-producto entre las puntuaciones escalares del diferencial semántico (d) y de Thurstone (t) con respecto a tres objetos de

juicio, en la sesión inicial de examen (rd1t1,) y en la segunda sesión (rd2t2);

en las columnas (3) y (4) se ofrecen los coeficientes de confiabilidad de test-retest con respecto a las escalas de Thurstone (rt1t2) y las puntuaciones evaluativas

en el diferencial (rd1d2), nuevamente para cada uno de los tres conceptos juzgados.

Puede verse que las confiabilidades de los dos instrumentos

son altas y equivalentes. La correlación entre las puntuaciones del diferencial semántico y las puntuaciones correspondientes de Thurstone es significativamente

más grande de la que podría atribuirse al azar (p < .01) en cada caso; y en ninguno de estos la correlación entre las técnicas fue significativamente menor

que el coeficiente de confiabilidad del test de Thurstone. Las diferencias en

las correlaciones entre ambas técnicas, de la primera a la segunda sesión de examen, están dentro de los límites del azar. Claro está que cualquiera que sea lo que

midan las escalas de Thurstone, el factor evaluativo del diferencial semántico mide más o menos lo mismo. Ciertamente, cuando los seis coeficientes de validez se

corrigen por atenuación, se elevan a .90 o más. Comparación con una escala de Guttman.

En una revisión para examinar la validez del factor evaluativo del diferencial como medida de actitud en contraste con una escala

del tipo de Guttman. Se construyó una escala de 14 reactivos, del tipo Guttman (coeficiente de reproductibilidad de .92), con gran inversión de tiempo y

trabajo, para evaluar las actitudes de los agricultores hacia la práctica agrícola de la rotación de cultivos. Aproximadamente al mismo tiempo se usó el

diferencial semántico en conexión con una serie de programas de televisión que trataban de prácticas agrícolas y uno de los conceptos incluidos fue la rotación

de cultivos. Aunque estos estudios se realizaron independientemente, se encontró

que 28 sujetos habían sido sometidos a ambos instrumentos de examen. La escala de Guttman se había aplicado primero en todos los casos y el lapso entre los dos

exámenes varió considerablemente, desde solo tres días hasta casi cuatro semanas. Con las puntuaciones de actitud, en el diferencial, obtenidas sumando

las tres escalas evaluativas que se emplearon (bueno-malo, justo-injusto y valioso-insignificante) la correlación de orden de rango entre los dos

instrumentos fue muy significativa (rho = .78; p < .01). Por lo que se puede decir que la escala de Guttman y las escalas evaluativas del diferencial miden

en alto grado la misma cosa. Los resultados de estos dos estudios corroboran la noción de que el factor

evaluativo del diferencial semántico es un índice de actitud. Además, es un método de evaluación de actitudes relativamente fácil de aplicar y calificar.

Aunque no explora mucho el contenido de una actitud en el sentido del significado denotativo (por ejemplo, las reacciones específicas que presentarían

personas con diferentes actitudes, las aseveraciones específicas que podrían aceptar), parece proporcionar un índice de la ubicación del objeto de actitud a

lo largo de un continuo evaluativo general. Si el diferencial semántico en conjunto puede proporcionar un cuadro de mayor riqueza del significado del

objeto de actitud que la dimensión evaluativa solamente en conjunto puede proporcionar un cuadro de mayor riqueza del significado del objeto de actitud

que la dimensión evaluativa solamente, en un punto que se verá mas tarde.

Articulo Noviembre 2008 UNA TÉCNICA PARA ELABORAR ESCALAS DE ACTITUDES (II)

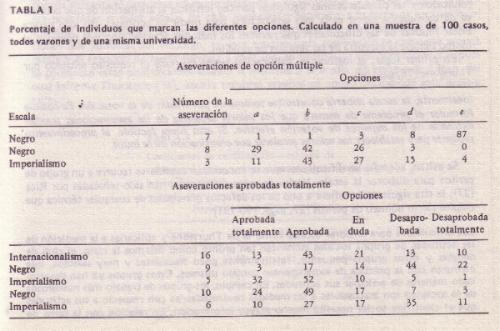

Análisis de reactivos Los 83 reactivos se adaptaron a respuestas del tipo de Likert.

Cada uno de ellos fue seguido por una escala obligatoria de 6 puntos (completamente de acuerdo, de acuerdo, ligeramente de acuerdo, ligeramente en

desacuerdo, en desacuerdo, completamente en desacuerdo). Se pidió a los sujetos que marcaran en cada reactivo la expresión que describiera mejor su propia

actitud hacia aquél. En total, 355 sujetos llenaron el cuestionario: 245 de clases de sociología, psicología e idiomas, de la Universidad de Washington; 60 de una

preparatoria local y 50 de una escuela de policías. De los 355 cuestionarios quedaron 346, porque 9 de ellos estaban incompletos o tenían más de una

respuesta en algún reactivo. La calificación se hizo de acuerdo con el método general de Likert, asignándose

valores de 0 a 5 a las 6 categorías de respuesta; el valor 5 fue para la respuesta completamente de acuerdo, en el caso de reactivos que expresaban una

opinión favorable sobre la ciencia; y también para la respuesta completamente en desacuerdo en los reactivos que expresaban una opinión desfavorable sobre la

ciencia. En cuanto a los 6 reactivos dentro del intervalo escalar de 4.0 a 4.9, la asignación de valores se hizo basándose en que el valor escalar del reactivo fuera

mayor o menor que 4.5. A cada sujeto se le sumaron los valores de las respuestas

en los 83 reactivos individuales y se dibujó una distribución de frecuencia de las puntuaciones resultantes. La amplitud obtenida de las puntuaciones fue

solamente el 64% de la amplitud posible (la obtenida de 140-405, la posible de 0-415) con una gran giba en el extremo superior (favorable) de la distribución.

Se escogieron dos grupos de criterio, aproximadamente el 27% superior e inferior, sobre la base de las puntuaciones totales. La amplitud de las

puntuaciones con respecto a los 94 cuestionarios inferiores fue de 140 a 300 y los 94 superiores tuvieron puntuaciones desde 343 hasta 405. Las 83

aseveraciones se sometieron entonces a análisis de reactivos. Para cada una, se tabularon las frecuencias en cada una de las categorías de respuesta tanto para

el grupo superior como para el inferior. Las 6 categorías se redujeron a 2, combinando las categorías 0, 1, 2, 3 y 4. Esta agrupación fue necesaria porque

los sujetos dieron respuestas predominantemente favorables a los reactivos. Si el universo de contenido hubiera sido la actitud hacia los sindicatos, se

hubiera esperado una distribución más simétrica de las respuestas y, consecuentemente, una agrupación diferente de las categorías. A partir de las tablas de 2 x 2

resultantes, se calcularon los coeficientes fi (11) (Φ), que variaron desde 16 a 0.78. Los nomogramas de Guilford y las tablas preparadas por Jurgensen

simplifican estos cálculos. Los 83 reactivos se dibujaron en una distribución bivariada con los valores (Φ)

sobre el eje Y y los valores escalares sobre el eje X. Una gráfica de los valores de fi, en contraste con los valores de Q, no

indicó relación discernible; y la variabilidad dentro de las columnas fue aproximadamente igual a la variabilidad total. Esto indicaría que en el

procedimiento de discriminación escalar seguido, el análisis de fi vigoriza el proceso de selección de reactivos cuando se usan reactivos con valores de Q

semejantes. En este momento se han eliminado ya el 50% de los reactivos con los valores de Q mayores.

Se seleccionaron de cada mitad del intervalo escalar los 4 reactivos con los mayores coeficientes fi;

debido a los huecos mencionados en el continuo de la escala solamente se abarcaron los intervalos entre .5 y 2.5 y entre 6.5 y 8.0. No se seleccionaron

reactivos entre los controles "neutrales" en el intervalo escalar de 4.0 a 4.9. Los 28 reactivos así seleccionados se asignaron a las formas A y B de los

cuestionarios, alternándose los valores escalares entre ambas formas.

Las escalas finales fueron de 14 reactivos cada una, con reactivos aproximadamente iguales en cuanto a valores escalares de Thurstone, valores Q y

valores fi. En las formas A y B, respectivamente, los valores escalares medios de los 14 reactivos fueron 3.85 y 3.91, los valores Q medios fueron .90 y .92.

Los coeficientes fi de los reactivos, en la forma A, variaron entre .58 y .78 con un valor mediano de .65; en la forma B variaron desde .58 a .76 con un

valor mediano de .66. Solamente 1 de los 10 reactivos de control restantes tuvo un valor fi por encima de .58. Fue precisamente uno de los 6 reactivos

"neutrales" el que tuvo un valor fi de .61. Los demás reactivos de control serían rechazados según el criterio fi.

CONFIABILIDAD Y REPRODUCTIBILIDAD DE LA ESCALA

El coeficiente de confiabilidad de las dos formas de la escala, de 14 reactivos, cada una, calculado según las respuestas de 248 sujetos

nuevos fue de .81, no corregido. Para ambas formas del test se restringió completamente la amplitud de las puntuaciones, de 30 a 70 en cada caso, con

amplitudes posibles de 0 a 70. Dentro de esta amplitud restringida se presentó una giba en el extremo superior o favorable. La puntuación media con respecto a

la forma A fue de 58.22 y la desviación estándar de 7.33. En cuanto a la forma B, la media fue de 57.20 y la desviación estándar de 7..79.

Se realizó el análisis escalar basado en la ejecución de una muestra de 87 sujetos extraídos de un grupo mayor de 248, en ambas formas del

test por medio de la técnica de Cornell (11). Se obtuvo un coeficiente de reproductibilidad de 87.5% con respecto a la forma A y un coeficiente de 87.2%

para la forma B. Las categorías de respuesta en cada caso se dicotomizaron.. Se establecieron puntos de corte y se observo la regla de Guttman de que "ninguna

categoría debe tener mayor número de errores que de aciertos". La amplitud de la categoría de respuesta modal fue de .51 a .82 en la forma A. El valor medio de

las categorías modales, .57, que es el valor mínimo del coeficiente de reproductibilidad para este conjunto de reactivos en la muestra usada, puede

compararse con el coeficiente observado de reproductibilidad del 87.5%. Este es el límite inferior porque la reproductibilidad de cualquier reactivo no puede

ser menor que la frecuencia de la categoría modal. El método para computar el valor mínimo del coeficiente supone independencia entre los reactivos. En cuanto

a la forma B, la amplitud de las categorías modales fue de .52 a .67. El valor medio, que es nuevamente el límite inferior del coeficiente de

reproductibilidad, fue de .57, mientras que el valor observado del mismo coeficiente fue del 87.2%.

Los dos valores observados del coeficiente de reproductibilidad son suficientemente altos para ofrecer pruebas de que una sola

variable dominante está comprendida en los grupos de reactivos o que, dicho de otra manera, existe monodimensionalidad. Se dice que tales grupos de reactivos

son adaptables a una escala o que constituyen una escala. Los coeficientes de reproducibilidad también significan que es posible reproducir las respuestas a

los reactivos a partir de las puntuaciones de orden jerárquico con el grado de exactitud indicado por el valor de aquellos mismos.

El error de reproductibilidad presente es sencillamente igual a 1.00 menos el coeficiente observado de reproductibitidad. Si puede suponerse

que tal error es al azar, entonces estos grupos de reactivos poseen una propiedad importante: la simple correlación entre las puntuaciones de orden

jerárquico y un criterio externo será igual a la correlación múltiple entre los reactivos y el criterio externo. Y esto, a su vez, significa que la eficiencia

de la predicción se hace máxima por la simple correlación. Sería igualmente verídico que en el caso de grupos de

reactivos que satisfacen los criterios exigidos para las escalas, la interpretación de las puntuaciones de orden jerárquico no es ambigua, y que es

posible hacer afirmaciones significativas tocante a que un sujeto es superior (más favorable) que otro en la variable en cuestión. En el caso de escalas

perfectas, donde el coeficiente de reproductibilidad es la unidad, se infiere igualmente que un individuo con una puntuación de orden jerárquico baja no daría

una respuesta más favorable a cierto reactivo que cualquier persona con una puntuación de orden jerárquico más alta.

Esto no sería cierto en un test que incluyese más de una variable. Supongamos, por ejemplo, que un test comprende dos variables. Entonces

un sujeto puede obtener determinada puntuación superior en una variable e inferior en la otra. Otro sujeto podría obtener la misma puntuación y ser

superior en la segunda variable e inferior en la primera. A partir de las puntuaciones de orden jerárquico únicamente, sería imposible indicar las

posiciones relativas de los sujetos en las dos variables; y, por tanto, es ambigua la interpretación de la puntuación compuesta. Podrían hacerse

afirmaciones de "mayor y menor que"; pero no sabriamos a qué se referiría el "mayor y menor que", porque al incrementar o disminuir el número de reactivos

relacionados con una de las variables, podrían alterarse las puntuaciones de orden jerárquico de los sujetos, no significa esto que las escalas

multidimensionales carezcan de valor. Esto no sería verdadero en un test donde todos los reactivos pertenecieran a un sólo continuo, es decir, en un test

monodimensional. En tal tipo de test, el incremento del número de reactivos no cambiaría las puntuaciones jerárquicas de los sujetos.

RESUMEN

Al método de discriminación escalar descrito ha recibido el nombre, por usar el procedimiento de elaboración de escalas de Thurstone; y

reserva el procedimiento de Likert para evaluar el poder discriminativo de los reactivos individuales. Además, los reactivos seleccionados por el método de

discriminación escalar, producen coeficientes de reproductibilidad satisfactorios y satisfacen los requisitos del análisis escalar de Guttman. El

método de discriminación escalar es esencialmente una síntesis de los métodos de evaluación de reactivos de Thurstone, Likert y Guttman. También posee ciertas

ventajas que no están presentes en ninguno de estos métodos, considerados separadamente.

Por ejemplo el método de discriminación escalar elimina los reactivos menos discriminantes en una muestra grande, tarea en la que falla el

metodo de Thurstone solo. El problema no resuelto en el procedimiento de Thurstone es el de seleccionar dentro de cada intervalo escalar los reactivos

más discriminantes. Los reactivos dentro de cualquier intervalo escalar pueden presentar un alto grado de variabilidad con respecto a una medida de

discriminación. Por ejemplo, encontramos dentro de un sólo intervalo reactivos con valores fi que van desde .24 a .78. Que el criterio Q de Thurstone no

ayuda materialmente a la selección de los reactivos discriminantes, lo índica la gráfica de los valores de fi contra los valores de Q, después que se ha

rechazado el 50% de los reactivos con los valores Q mayores. En tal circunstancia, los reactivos con valores de Q, desde 1.00 hasta 1.09, tuvieron

valores fi que oscilaban entre .32 y .76. El método de Thurstone, por la inclusión de reactivos "neutrales", tiende también a disminuir la confiabilidad

y la reproductibilidad del grupo de reactivos seleccionado finalmente. Por tanto, cuando seleccionamos reactivos únicamente por la

técnica de Thurstone, no tenemos base para seleccionar reactivos con valores escalares y valores Q semejantes, pese a que estos reactivos no sean igualmente

valiosos para la medición de actitudes. Disponiendo de alguna medida del poder discriminante de los reactivos, la selección se vuelve objetiva así como

ventajosa por lo que se refiere a la escala misma. La ventaja del método de discriminación escalar con respecto

al procedimiento de Guttman se basa esencialmente en el hecho de qué hemos suministrado una base objetiva para la selección de un conjunto de reactivos que

después son examinados en cuanto a su adaptabilidad a la escala. Es posible que el método de discriminación escalar no siempre produzca un conjunto de reactivos

con un coeficiente de reproductibilidad satisfactorio. Pero ésta no es una objeción mayor a la técnica, sino tan sólo la manifestación del hecho de que un

conjunto de reactivos seleccionados intuitivamente no siempre será adaptable a una escala. Al parecer, el método de discriminación escalar ofrece mayor

garantía de factibilidad de una escala que cualquier técnica intuitiva, como la aplicada por Guttman.

Además, el conjunto de reactivos seleccionado por la técnica

de discriminación escalar suministra una amplitud mayor de contenido que los reactivos intuitivos de Guttman. Por el método de discriminación escalar,

obtenemos reactivos que no son primordialmente expresiones múltiples de la misma pregunta, como a menudo sucede cuando la selección de un conjunto de reactivos

que van a ser examinados en cuanto a su adaptabilidad a la escala se deja a la experiencia del investigador.

BIBLIOGRAFIA

Articulo Octubre 2008 UNA TÉCNICA PARA ELABORAR ESCALAS DE ACTITUDES (I)

En artículos anteriores, se ha pasado revista a varios de los métodos que se siguen para elaborar escalas de actitudes; el método de intervalos

aparentemente iguales, desarrollado por Thurstone; el método de estimaciones sumatorias, desarrollado por Likert y el método de análisis

escalar creado por Guttman. El método de intervalos aparentemente iguales y el de estimaciones sumatorias son similares en cuanto que suministran técnicas

para seleccionar, de un numero grande de reactivos, un conjunto que constituye el instrumento de medida. El análisis escalar difiere de estos dos métodos en

que se ocupa de la evaluación de un conjunto de reactivos, después de que estos, de uno u otro modo, ya han sido seleccionados.

En el método de intervalos aparentemente iguales, un grupo de peritos clasifica reactivos de opinión en 9 u 11 categorías que constituyen un continuo que varia

de desfavorable a favorable. El valor escalar de cada reactivo se determina por el punto del continuo, por encima y por debajo, en el cual el 50% de los peritos

colocan tal reactivo. La dispersión de las estimaciones de los peritos se mide por Q, la amplitud intercuartilar. Un valor de Q alto para un reactivo indica

que los peritos están en desacuerdo con la ubicación del reactivo en el continuo, lo que a su vez significa que el reactivo es ambiguo. Tanto los

valores de Q como los escalares se usan en la selección de reactivos para el test de actitud. Con tal propósito se seleccionan aproximadamente 20 reactivos

con valores escalares espaciados igualmente a lo largo del continuo y con valores de Q pequeños. Se determinan las puntuaciones del test hallando la

mediana de los valores escalares de los reactivos con los que esta de acuerdo el sujeto. En el método de estimaciones sumatorias se seleccionan reactivos con un criterio

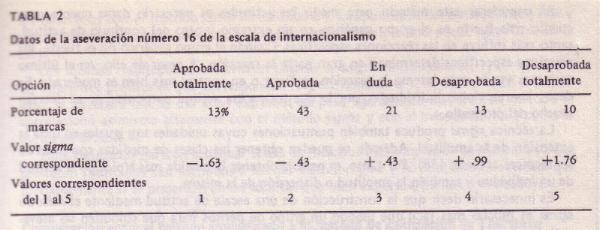

de consistencia interna. Los sujetos indican si están: completamente de acuerdo, de acuerdo, en duda, en desacuerdo o completamente en desacuerdo, con cada

reactivo. Se asignan valores numéricos a estas categorías de respuesta usando los enteros sucesivos de 0 a 4; el valor más alto se asigna consecuentemente a

la categoría que indica la actitud más favorable. Se selecciona un grupo superior y uno inferior, con base en las puntuaciones totales obtenidas de la

suma de los valores de los reactivos. Después se comparan las respuestas de estos dos grupos en los reactivos individuales; y los 20 reactivos más

discriminantes o poco más o menos se seleccionan para el test de actitud. Una puntuación de actitud en este test se determina sumando los valores asignados a

las respuestas del sujeto a los 20 reactivos. En el análisis escalar, se prueba un conjunto completo de reactivos para

determinar si, como grupo, constituyen una escala en el sentido de que a partir de la puntuación de orden jerárquico sea posible reproducir la respuesta de un

sujeto a los reactivos individuales. El grado en que esto es posible se expresa por el coeficiente de reproductibilidad. Aunque ordinariamente Guttman emplea

de 10 a 12 reactivos, para explicar con claridad ate coeficiente supongamos que tenemos tres reactivos, cada uno con sólo dos categorías de respuesta: de

acuerdo y en desacuerdo. Supondremos que la respuesta "de acuerdo", en cada caso, representa una actitud favorable y la respuesta "en desacuerdo" una

actitud desfavorable. Se asigna el valor 0 a la respuesta en desacuerdo y el valor 1 a la respuesta de acuerdo. Supongamos también que con respecto al primer

reactivo tenemos en nuestra muestra 10 sujetos con valor 1, y 90 con valor 0; con respecto al segundo reactivo tenemos 20 sujetos con valores de 1, y 80 con

valores de 0; y para el tercer reactivo tenemos 40 con valores de 1, y 60 con valores de 0. En el caso de reproductibilidad perfecta, los 10 sujetos con valor 1 en el

primer reactivo serán los 10 sujetos con las puntuaciones de orden jerárquico más altas. Estos 10 sujetos también estarán comprendidos en los 20 que tienen

valor 1 en el segundo reactivo; y estos 20 a su vez estarán comprendidos en los 40 que tienen valor 1 en el tercer reactivo. En la misma forma sería cierto que

solamente se presentarían 4 patrones de respuesta de reactivo, si el conjunto de estos fuera perfectamente reproductible. Tocante a la muestra disponible, los

patrones y puntuaciones asociadas a ello; serían: AAA-3; DAA-2; DDA-1; DDD-0. Establecido que todas las respuestas podrían predecirse perfectamente a partir

de las puntuaciones, en este caso, el coeficiente de reproductibilidad sería del 100%. Sin embargo, rara vez se obtiene una reproductibilidad perfecta y en la

práctica se considera satisfactorio un coeficiente del 85% o más, para que un conjunto de reactivos constituya una escala. Se han desarrollado varias técnicas

para computar el coeficiente de reproductibilidad, que han sido documentadas por Festinger, Clark y Kreidt y Guttman. Además del coeficiente de reproductibilidad (10, 12), existen

otros criterios que se aplican para determinar si un conjunto de reactivos constituye una escala. Sin embargo, poco se ha publicado tocante a los casos en

que se han aplicado empíricamente estos criterios a un conjunto concreto de datos. El coeficiente de reproductibilidad ha sido destacado en todas las

publicaciones de Guttman, quizá porque se considera una condición primaria e inevitable, pero insuficiente, de una escala.

El análisis escalar, en el sentido antes mencionado, se convierte entonces en una técnica secundaria dentro del problema de la selección

de reactivos; esto no niega la importancia de la teoría que fundamenta el análisis escalar. Lo importante es obtener un conjunto de reactivos que den

alguna seguridad al investigador de que formarán una escala cuando se aplique una técnica particular para probar su adaptabilidad a una escala. Hasta época

reciente, el problema de la selección de reactivos en el análisis escalar parece haberse dejado a la intuición y experiencia del investigador. Las únicas reglas

prácticas sugieren que uno debe expresar, sencillamente, la misma pregunta, de maneras ligeramente diferentes, o que uno debe buscar reactivos cuyo contenido

sea lo más homogéneo posible. Esta última recomendación implica que, si estuviéramos interesados en el problema de la actitud hacia los negros, deberíamos dividir

este universo de contenido en subuniversos que constituyeran tal vez áreas tales como la actitud hacia los negros en restaurantes; la actitud hacia los negros

como residente en la comunidad, como votantes y como patrones; la actitud hacia los negros en los transportes públicos y así sucesivamente. Pero aún aquí

encontramos que la actitud hacia los negros, digamos en los transportes públicos, puede dividirse en áreas de contenido aún más homogéneas al

especificar los transportes: tranvías, autobuses, trenes, aviones, etc. Cada una de estas áreas de contenido quizás pueda dividirse en otras aún más homogéneas y

vendríamos a terminar seguramente como !o indica Festinger, con múltiples expresiones de la misma pregunta; y así nuestras dos reglas no son sino una.

Cualquier técnica que nos permitiera seleccionar un conjunto de reactivos del conjunto más grande de posibles reactivos, con cierta seguridad

en que el conjunto seleccionado llenaría los requisitos del análisis escalar, sería de gran valor. En este artículo se describe una técnica que ha tenido

éxito en la tarea. Por razones que se conocerán más adelante, hemos llamado a esta técnica "método de discriminación escalar para elaborar escalas de

actitud". LA TÉCNICA DE DISCRIMINACIÓN ESCALAR El método de discriminación escalar se basa en

investigaciones previas que mostraron que el punto de corte (el punto de corte de un reactivo indica el lugar de las puntuaciones de orden jerárquico de los

sujetos donde la respuesta más común cambia de una categoría (de acuerdo) a la siguiente (en desacuerdo). Entre los puntos de corte de una escala perfecta,

todas las respuestas caen en la misma categoría.), de un reactivo está relacionado con el valor escalar thurstoniano del reactivo; y que su

reproductibilidad (la reproductibilidad de un reactivo se mide por el grado en que pueden reproducirse las respuestas al reactivo a partir de las puntuaciones

de orden jerárquico de los sujetos) se vincula con su poder discriminativo. Este, como ya se hizo notar, no es, contra lo que pudiese

parecer a primera vista, solamente una función del valor escalar del reactivo. Puede demostrarse expeditamente que reactivos con valores escalares

thurstonianos y valores de Q semejantes pueden diferir grandemente en su eficacia para diferenciar los que tienen actitudes favorables de los de

actitudes desfaborables. Por ejemplo, el reactivo extremo: "Todos los xxxx deben ser ejecutados" indudablemente presentaría un valor escalar en un extremo del

continuo y un valor Q claramente pequeño. Pero este reactivo no establecerá diferencia entre los que tienen actitudes favorables o desfavorables hacia los

xxxx por la evidente razón de que ambos grupos probablemente reaccionarían a él del mismo modo. Se reunieron aseveraciones de opinión sobre ciencia, de muy

diversas fuentes. Se consultaron libros y ensayos. Se pidió a individuos que expresaran sus opiniones en breves afirmaciones escritas; y se lograron reunir

266 aseveraciones sobre el particular. En la edición de estos reactivos, se atendió especialmente a la eliminación de aquellos reactivos que: Gracias al cuidado con que se realizó la recolección y la edición de las aseveraciones, la mayoría de las 155 seleccionadas finalmente

expresaron una opinión claramente favorable o desfavorable hacia la ciencia. Otros 13 reactivos, que pudiésemos llamar de control, se

agregaron a los 155 originales. Estos 13 últimos se agregaron para determinar lo que les sucedía a lo largo de las diferentes etapas del método de discriminación

escalar. De los 13 reactivos, 7 se juzgaron "neutrales", en el sentido de Thurstone; 2 podían interpretarse como relativos a hechos precisos; uno se

consideró demasiado extremo para recibir muchas ratificaciones, otro se juzgó ambiguo porque las palabras "scientific holiday" (festividad científica) podrían

interpretarse como una moratoria o como una celebración; otro más se consideró ambiguo porque comprendía más de una dimensión; y un último se consideró

inadecuado. Había, en consecuencia, 168 reactivos que se emplearon para probar el método de discriminación escalar de elaboración de escalas. Debe recalcarse

que la inclusión de reactivos de "control" no se considera parte del procedimiento de discriminación escalar Determinación de los valores escalares y valores Q de los

reactivos Se prepararon sobres numerados del 1 al 110. En cada sobre se colocó un conjunto de tarjetas de 8 x 12 cm. marcadas con las letras A, B, C, D,

E, F, G, H, I y un paquete de tiras de papel de 5 X 10 cm aproximadamente. En cada tira de papel, se imprimió uno de los 168 reactivos junto con el número del

reactivo. En cada caso se barajó el paquete de tiras de modo que los reactivos quedaran absolutamente desordenados. Se entregaron los sobres a un grupo de

estudiantes de la clase de psicología elemental, junto con las instrucciones que describen el procedimiento de clasificación de Thurstone, y se les pidió que

clasificaran los reactivos de acuerdo con las instrucciones. Se examinaron las clasificaciones de cada sujeto y se

descartaron aquéllos cuyas clasificaciones presentaban inversiones obvias del continuo o que no atendieron las instrucciones. Sobre esta base se quedaron con

82 grupos de juicios. Se tabularon las frecuencias de juicio en cada una de las 9 categorías con respecto a cada reactivo; se transformaron en frecuencias

acumulativas y después en proporciones acumulativas, ( Esta tarea fue muy laboriosa. Casi 14000 tiras de papel tuvieron que clasificarse para después ser

tabuladas. Algunas técnicas de juicio similares a las empleadas por Ballin y Famworth o Seashore y Hevner reducirían mucho este trabajo, pero aún así

la tarea no es sencilla. Varios métodos que simplifican el proceso de juicio se están usando actualmente). Se dibujó la ojiva correspondiente a cada reactivo; las

proporciones acumulativas se colocaron en el eje de las ordenadas y los valores escalares en el eje de las abscisas. Estos valores se escribieron con dos cifras

decimales (el segundo decimal fue solamente una aproximación) las cuales se obtuvieron trazando una perpendicular a la línea base de los valores escalares

en el punto donde la curva de proporción acumulativa cruzó la marca del 50%. De manera similar se determinaron valores Q trazando perpendiculares en los niveles

del 25 y 75%; Q era la distancia entre estos dos puntos, o sea la amplitud intercuartilar; (Esta operación se simplificó estableciendo una gráfica maestra

con las proporciones acumulativas en el eje Y y los valores escalares en el eje X. Se enrolló la gráfica en una placa de vidrio granulado que se adaptó a una

caja de madera cerrada que contenía un bulbo de 100 vatios. Luego se colocó papel para dibujar sobre dicha gráfica y se representaron rápidamente las ojivas

de los reactivos individuales.) Posteriormente se dibujaron los 168 reactivos en una distribución bivariada de acuerdo con los valores escalares y de Q; los valores

escalares se representaron en la línea base. La distribución de estos adquirió la forma bimodal. Hubo muy pocos reactivos en la zona "neutral" (ninguno entre

5.0 y 5.9); las categorías modales iban de 1.0 a 1.9 y de 7.0 a 7.9. Los valores Q de los 7 reactivos que cayeron en el intervalo escalar "neutral" (de 4.0 a

4.9) fueron muy bajos; 6 de ellos cayeron por debajo del valor Q mediano de los 168 reactivos. Estos 7 reactivos fueron los de "control", descritos

anteriormente. Se dibujó una línea a través de la distribución aproximadamente en la mediana de los valores Q de todos los reactivos, en 1.29.

Todos los reactivos con valores Q por encima de este punto fueron rechazados. A partir de este momento trabajamos solamente con los 83 reactivos restantes, o

sea aproximadamente el 50% del conjunto inicial de reactivos con el menor grado de ambigüedad según es medida por Q. Uno de los reactivos de control "neutral"

se eliminó por medio de este estándar; pero 6 fueron aceptables. Estos 6 reactivos tuvieron valores escalares entre 4.0 y 4.9. Ningún reactivo se

encontró en el intervalo escalar de 5.0 a 5.9 y el criterio de Q eliminó a todos los que estuvieran dentro del intervalo de 3.0 a 3.9. Uno de los 2 reactivos

referente a hechos precisos fue eliminado por el criterio de Q y también se eliminó el reactivo ambiguo con las palabras "scientific holiday". Los 10

reactivos restantes de control se consideraron aceptables por medio del criterio Q.

Articulo

Septiembre 2008 COMO ELABORAR ESCALAS TECNICAS DE GUTTMAN

LA FUNCIÓN DE INTENSIDAD. Guttman (1954) concibió dos métodos para ordenar a los individuos sobre un

continuo de contenido. Uno de ellos, que se utiliza habitualmente y queda sobreentendido, hace uso de los marginales de respuesta, que se observan en los

reactivos seleccionados a partir de un universo de actitud, para obtener puntos de corte o para establecer rangos de contenido.

El otro método utiliza puntos de torsión de las regresiones de los componentes principales superiores de

actitudes mensurables, para obtener los diferentes puntos de corte.

Con base en un modelo matemático, se han propuesto cuatro variables psicológicas como componentes principales de actitudes mensurables por escala. La intensidad, segundo componente, se concibe como un medio para obtener una dicotomía de los sujetos, a lo largo de un

continuo de contenido, en actitudes positivas y negativas. El tercer componente,

identificado provisionalmente como cierre, se pretende que discrimina entre los sujetos dentro de la dicotomía positiva-negativa. Por tanto, se considera que la

función del tercer componente es la de colocar a los sujetos en posiciones de positivo extremo, positivo moderado, negativo moderado y negativo extremo.

Se supone que cada componente principal superior da lugar a puntos de corte

teóricamente más objetivos y más significativos. El análisis matemático, de Guttman, propone un número

infinito de componentes principales para las escalas perfectas. Este análisis matemático, que usa el criterio de consistencia interna máxima, en el sentido de

mínimos cuadrados, predice también el tipo de curva obtenida cuando la regresión de un componente se dibuja sobre el orden jerárquico original de las escalas

perfectas. En relación con éstas, la primera mejor solución produce una

relación lineal. La segunda mejor solución establece el segundo componente, que da una curva en forma de U y un solo punto de inflexión. Se obtiene un punto de

torsión adicional para cada solución o componente superior sucesivo. Aunque Guttman informa de cierto grado de éxito en la prueba

del cierre y de la involución como referentes empíricas de los componentes matemáticos tercero y cuarto, la investigación subsecuente indica que estas

variables componentes y otras más que ha propuesto no satisfacen los criterios fijados por el modelo matemático (Henry, 1957; Riland, 1959; Dotson, 1962). Sin

embargo, es común que se establezca el contenido y la intensidad. El primer componente es el del contenido con respecto a un

universo específico de actitud. Por ejemplo, la actitud entre los blancos sureños hacia la segregación de los negros podría ser ese universo mensurable de

contenido. El segundo componente, considerado generalmente, es la

intensidad con que se mantiene la actitud. Cuando se dibuja la intensidad de la actitud en contraste con su rango de contenido, debe obtenerse una curva en

forma de U, en la que los sujetos más negativos y los más positivos muestran intensidades altas. La investigación empírica sugiere que el punto de torsión de

la curva de intensidad indica un "punto de indiferencia" o punto cero, en el orden jerárquico fundamental. Guttman, (1954) además, sostiene que el punto de

inflexión separa a los sujetos en tipos escalares positivos o negativos, según a qué lado del punto cero estén ubicados.

Brim adopta una posición diferente. Indica que "las respuestas de contenido a las preguntas de actitud se basan en una clase de expectativas

P1, que se refieren a probabilidades acerca de la satisfacción que se logrará en varios estados de cosas" (1955,). El cree que la intensidad o "fuerza del

sentimiento" es equivalente a una estimación P2 de que la primera expectativa es correcta". Brim indica que el punto de torsión de la curva de intensidad señala

a los sujetos que no saben si deberían o no estar satisfechos con el estado de cosas que describen los reactivos. De esta manera, los sujetos que caen en tipos

escalares a un lado del punto cero se definen como aquéllos que estiman la probabilidad de satisfacción superior al 50%. Los que caen al otro lado

(negativo) se definen como aquéllos que estiman la probabilidad de satisfacción inferior al 50%. Esta es en esencia la discusión de Brim y Guttman, muchos

investigadores adoptan la posición de Henry: Si se acepta que el punto cero define a aquéllos que no saben

cuál sería su satisfacción probable -por consiguiente, la estiman 50-50 de acuerdo con un principio de "equiprobable por defecto de la ignorancia"- o que

define a aquéllos que no les interesa o son indiferentes, parece que nos hallamos ante una técnica útil para separar los favorables de los desfavorables

(1957). Pueden obtenerse medidas de intensidad ya sea por la técnica

de doblado o por la de bipartición, ninguna de las cuales forma escalas en el sentido de Guttman (Suchman, 1950). La técnica de doblado implica el uso de

reactivos que midan las dimensiones de contenido e intensidad simultáneamente. Para obtener puntuaciones de intensidad mediante esta técnica, con reactivos

compuestos de seis categorías de respuesta, las categorías positiva extrema y negativa extrema se combinan o "doblan" para obtener valores de intensidad más

altos; las categorías positiva media y negativa media se combinan para formar una puntuación de intensidad baja; y las respuestas positiva mínima y negativa

mínima se doblan para formar el valor de intensidad más bajo. Se asignan después valores arbitrarios, por ejemplo 2, 1 y 0 a las tres categorías de intensidades

respectivamente. De esta manera se da a cada sujeto una puntuación de intensidad con respecto a cada reactivo; y finalmente se suman las distintas puntuaciones

de intensidad de cada individuo. La técnica de bipartición emplea una pregunta de intensidad

diferente, con respecto a cada pregunta de contenido. Por ejemplo, después de un reactivo de contenido se formula una pregunta de intensidad como ésta: "¿Qué tan

profundo es su sentimiento con respecto a X? " Se utilizan opciones de respuesta del tipo 1. "muy profundo", 2. "mediano" y 3. "leve"; luego se asignan valores

arbitrarios y se suman según la respuesta de cada sujeto, como en la técnica de doblar. De ambos métodos, la técnica de doblado tiene la cualidad de economizar

espacio en un cuestionario; sin embargo, la técnica de bipartición proporciona mayor rigor, en la medición debido a la independencia de las medidas de

contenido e intensidad. La tabulación transversal de las puntuaciones de intensidad y

contenido de todos los sujetos, sirve para ubicar el punto de indiferencia o punto cero en el continuo del contenido. Después de colocar a los sujetos en los

tipos escalares definidos por los puntos de corte, resultantes de la observación de marginales de respuesta en reactivos de contenido, se computa el rango

mediano de intensidad para cada rango de contenido. La curva de estas medianas se usa como una aproximación a la curva de regresión del segundo componente

intrínseco. "Se usan las medianas y no las medias aritméticas o promedios similares, porque aquéllas son independientes de cualquier métrica, excepto del

orden jerárquico" (Suchman, 1950). Los valores correspondientes a los puntos dibujados se

determinan de la siguiente manera: Se computan porcentajes acumulativos con respecto a las

frecuencias totales tanto de contenido como de intensidad, acumulando del negativo al positivo en contenido y del menor al mayor en intensidad. Para

determinar el valor de contenido que se va a dibujar, calculamos el punto medio del intervalo de percentiles correspondiente a cada rango de contenido. El valor

de intensidad que se dibuja es el percentil de intensidad mediano del rango de contenido. . . (Suchman, 1950).

Para determinar la mediana de datos agrupados; es aplicable la fórmula general:

Mediana = lx +

(N/2 - fx acu/fx)(i)

donde lx es el límite inferior del intervalo que contiene a la mediana, N es el

número de casos incluidos en el análisis, fx acu es la suma acumulativa de las frecuencias absolutas hacia arriba, sin incluir el intervalo que contiene la

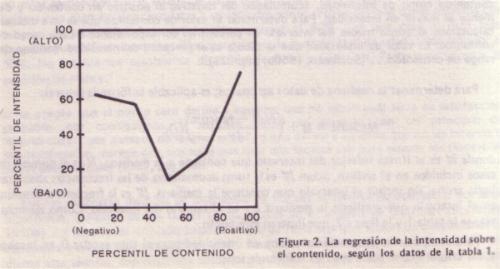

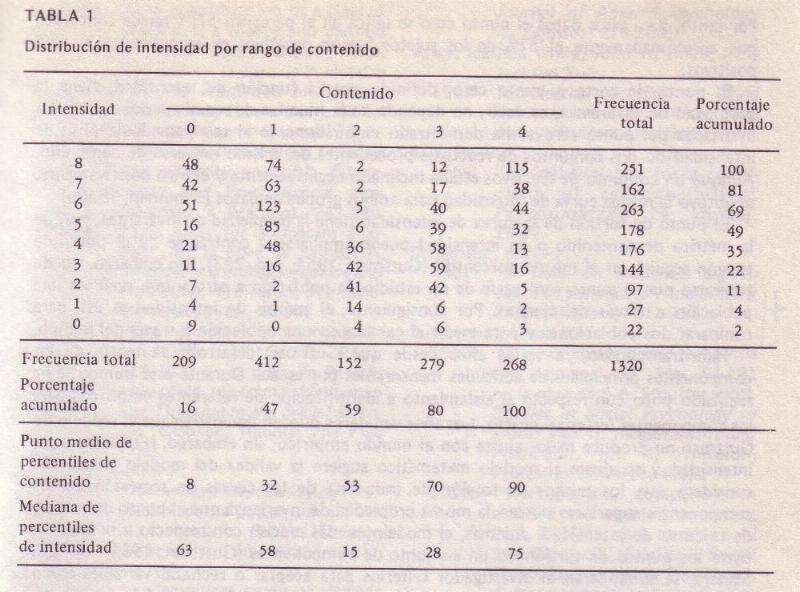

mediana, fx es la frecuencia absoluta en el intervalo que contiene la mediana e i es el tamaño del intervalo. Como ejemplo, véanse la tabla 1 y la figura 2, que

ilustran este punto. Para computar la puntuación mediana de intensidad para el tipo escalar 0, en la tabla 1, los valores que se sustituyen en la fórmula son:

Mediana = 49 + (209/2 - 68 )/51 (69 -49)

= 49 + (.71) (20) = 63. Este valor mediano de intensidad se dibuja después para representar el punto medio de rango 0 de

contenido, en la figura 2. Cuando se dibuja el valor mediano de la intensidad de cada uno de los rangos de contenido, se obtiene una curva de regresión en forma

de U o J (figura 2). El punto cero o zona de indiferencia, en la figura 2, se ubica en el tipo escalar 2. De esta manera, los tipos escalares 0 y 1 se definen

como negativos y los tipos escalares 3 y 4 como positivos. El procedimiento anterior

hace uso de la regresión de intensidad sobre el contenido para identificar la zona de indiferencia. Una ubicación más precisa del punto cero puede obtenerse

por medio de lo que Guttman llama la técnica de "punta de flecha", en la que la colocación se determina por la regresión del contenido sobre la intensidad. "La

estimación que se emplea es el percentil mediano de contenido del subgrupo con el rango de intensidad más pequeño (seleccionando, por ejemplo, no menos de 100

personas con este grupo de intensidad menor, a fin de conservar la confiabilidad del muestreo)" (Guttman, 1954).

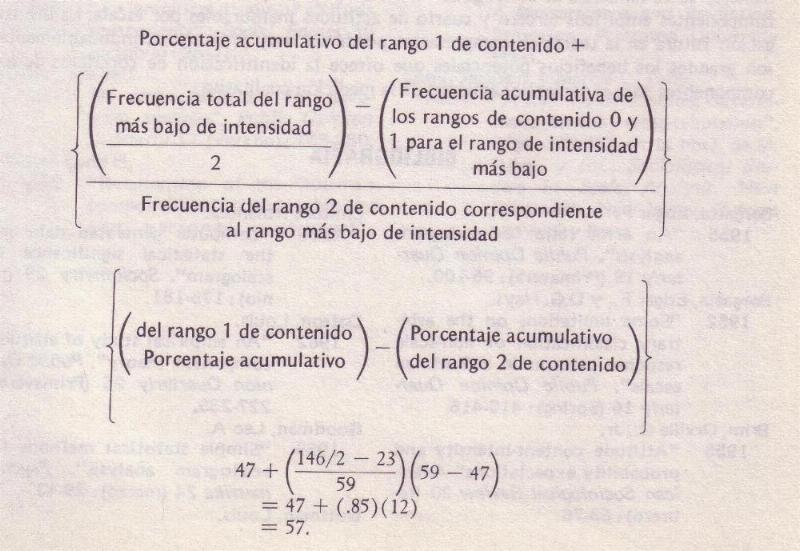

Usando la misma fórmula general anterior para calcular la mediana de datos agrupados, se determina el

punto cero correspondiente a los datos de la tabla 1, combinando los rangos de intensidad menores para proporcionar un número suficiente de observaciones.

Combinando los rangos originales de intensidad 0, 1 y 2, se colocan 146 sujetos en la categoría de intensidad más pequeña. La mediana cae en el rango de

contenido que incluye el caso número 73. Sumando transversalmente los rangos de contenido, se encuentra que la mediana cae en el rango 2 de contenido. La

mediana del percentil de contenido correspondiente al rango de intensidad más pequeño, en este caso, se obtiene entonces como sigue:

Por tanto, para estos datos el punto cero se ubica en el

percentil 57; y puede concluirse que aproximadamente el 57% de los sujetos fueron negativos en su actitud y el 43% positivos.

El punto de corte o punto cero, definido por la función de intensidad, tiene la propiedad de invarianza, es decir, no depende de la muestra

de reactivos que se use. La invarianza del punto cero se ha demostrado empíricamente al comparar los análisis de intensidad de dos conjuntos de

reactivos procedentes del mismo universo de contenido. Aunque un conjunto de reactivos estaba inclinado negativamente y el otro positivamente, se obtuvo la

misma curva de intensidad para ambos grupos de datos (Schuman, 1950). El punto de torsión de la curva de intensidad tiene la

propiedad de invarianza, porque la métrica de contenido o de intensidad puede ampliarse o contraerse "y el punto de torsión seguirá en el mismo porcentil" (Guttman,

1954). Sin embargo, puede esperarse que el punto cero varíe de un estudio de población a otro y que varíe en una población a través del tiempo. Por

consiguiente, el análisis de intensidad es útil para comparar dos poblaciones y para medir el cambio en una población a través del tiempo.

Han transcurrido ya varios años desde que Guttman desarrolló la teoría de los componentes principales de actitudes mensurables por escala.

Durante este tiempo se ha realizado poco con respecto al aislamiento e identificación de referentes empíricos para los componentes tercero y cuarto.

Los años venideros pueden demostrar que el modelo de Guttman no produce mejor ajuste con el mundo empírico; sin embargo, la utilidad de la intensidad y su

ajuste al modelo matemático sugiere la validez del modelo entero. Se considera que los puntos de torsión de cada una de las curvas de regresión de los

componentes superiores poseen la misma propiedad de invarianza que el punto de torsión de la curva de intensidad. Además, el modelo es más preciso con respecto

a la relación entre los puntos de torsión de un conjunto de componentes (Guttman, 1954). De esta manera, se suministran al investigador criterios para aceptar o

rechazar variables como componentes empíricos tercero y cuarto de actitudes mensurables por escala. La investigación futura en la teoría de componentes

puede ser muy provechosa. Indudablemente, son grandes los beneficios potenciales que ofrece la identificación de correlatos de los componentes para el

perfeccionamiento de la medición cualitativa.

COMO ELABORAR ESCALAS TECNICAS DE GUTTMAN Introduccion. Desde los primeros trabajos de Guttman, la escala monodimensional ha sido ampliamente usada por sociólogos y psicólogos sociales.

Su utilidad se revela no solamente por el número de científicos sociales que la han empleado sino por el número de mediciones diferentes para las que se ha

adaptado. Aunque desde su aparición han transcurrido ya medio siglo, que ha servido para evaluar exactamente su contribución a la sociología y a la

psicología social. Es verdad que la técnica de Guttman permite el tratamiento de

datos cualitativos sin hacer la discutible conversión a datos cuantitativos como se hace en algunas otras técnicas de elaboración de escalas. De esta manera, los

investigadores han reducido al mínimo las interpretaciones erróneas, al evitar suposiciones de medida equivocadas. Pero lo más importante para el desarrollo de

la ciencia conductual es que el modelo de Guttman contenga cierto mecanismo intrínseco (el coeficiente de reproductibilidad) por el cual uno se ve obligado

a examinar la consistencia interna de los reactivos que componen la escala.

Este mecanismo compele la atención hacia lo que realmente se

está midiendo. Aunque en ocasiones se han obtenido medidas "estériles", no

obstante las pruebas de consistencia interna, generalmente los requerimientos de

reproductibilidad han favorecido la mayor claridad conceptual. Es,

indudablemente, difícil examinar la consistencia interna de un conjunto de

reactivos sin ocuparnos de lo que realmente se está midiendo o, por lo menos, de

lo que se está haciendo variar en los reactivos, para explicar la variación de

las frecuencias de respuesta, de tos reactivos. Es asimismo inevitable la

obtención de mayor claridad conceptual sobre el requerimiento de que, cada vez

que se use una escala, su consistencia interna haya de ser reexaminada. Así,

cuando con un conjunto de reactivos puede hacerse una escala para un grupo pero

no para otro, o suceda lo anterior con un grupo particular en el tiempo 1 pero

no en el tiempo 2, es preciso explicar el porqué. La técnica de Guttman ha

suministrado además un modelo para la organización de datos colectivos y otros

no actitudinales (Rifey y colaboradores, 1954). Ha habido y han sido estimulados

los considerables esfuerzos por mejorar el procedimiento original, de Guttman,

para elaborar escalas. La mayoría de las mejoras al método de Guttman para construir

escalas, desde los últimos años de la década del 40, se han concentrado en las

técnicas para evaluar una escala (es decir, las técnicas para determinar con más

precisión el grado en que un conjunto de reactivos se convierte en una escala

eficaz) y en la mecánica de la elaboración de escalas cuando se utiliza equipo

electrónico de procesamiento de datos.

Aunque parece que existe mayor interés en los criterios del

reconocimiento de errores que en los criterios de prevención de los mismos, en

la construcción de escalas ha habido notables aportaciones. Entre ellas se han

seleccionado para su estudio:

La mecánica de Guttman de elaboración de Escalas La noción básica de la escala de Guttman o acumulativa es que

entre los reactivos que forman la escala existe una relación interna tal, que una persona que ratifica o concuerda con un reactivo que ocupa una posición

escalar dada, ratificará todos los reactivos que estén por debajo de ella en la escala. Si se sabe que una persona ratificó tres reactivos de una escala

compuesta de cuatro, se sabe también cuáles fueron los tres reactivos que ella ratificó. Por otra parte, todos los individuos que ratifiquen solamente tres

reactivos, ratificarán los mismos tres. De esta manera, es posible ordenar a los individuos en categorías o posiciones relativas definidas por las posiciones de

los reactivos ratificados. Es cierto, empero, que estas cualidades de la escala de Guttman se deterioran a medida que disminuye la consistencia interna.

Se han inventado varias técnicas para elaborar escalas de Guttman. En el trabajo inicial se usó la técnica de tablas de escalograma (Suchman,

1950). En este procedimiento se usaba una tabla compuesta de una serie de tablillas movibles en las que se colocaban marcas que representaban las

respuestas de los sujetos a cada reactivo. Las tablillas podían manipularse de tal manera que se podía determinar visualmente la consistencia interna de los

reactivos que componían la escala.

Se han desarrollado otras técnicas, que incluyen la técnica de Cornell (Guttman, 1947), el método de cuadrados mínimos (Guttman, 1941) y la

técnica de tabulación transversal (Toby y Toby, 1954), así como varias modificaciones de ellas para usarlas con equipo de procesamiento de datos y

computadoras electrónicas.

En algunas técnicas se emplean valores asignados arbitrariamente, los cuales se suman para obtener una puntuación escalar para

cada sujeto; en otras técnicas no se hace así. Pueden usarse valores, pero nada se gana con ello. A Stauffer se le da crédito por el desarrollo de una técnica

que no usa un sistema de valores. En esta técnica se determinan puntos de corte con respecto a reactivos de respuesta múltiple tratados en forma dicotómica al

tabular transversalmente cada reactivo con todos los demás. Se desarrolló con el fin de usarse en un clasificador electrónico de tarjetas, pero puede adaptarse

fácilmente para usarse con computadoras. Debido a su sencillez, este método, algo modificado, se resume más abajo. En esta técnica, como en otras que también

se usan para construir escalas de Guttman, debe predecirse el orden jerárquico de los reactivos antes de que los datos sean examinados. Al reactivo más difícil

(o el menos favorable) debe asignársele el rango 1, al siguiente más difícil, el rango 2,. . ., y al menos difícil, el rango n.

De esta manera, la confianza en una escala se incrementa en la medida en que la predicción del orden jerárquico de los reactivos se

fundamente en los datos. Para verificar la predicción del orden jerárquico, se determina la frecuencia de respuestas de cada categoría de respuesta con

respecto a cada reactivo. Por ejemplo, si cada reactivo tiene cinco opciones de respuesta, de "completamente de acuerdo", "de acuerdo", "en duda", "en

desacuerdo" y "completamente en desacuerdo", determínese la distribución de respuestas de cada reactivo y conviértanse en porcentajes acumulativos desde la

más positiva hasta la más negativa.

En el paso siguiente, esta información servirá para seleccionar los puntos de corte de los reactivos de selección múltiple que son

tratados dicotómicamente. Cuando los reactivos son verdaderamente dicotómicos, por ejemplo, si-no, de acuerdo-desacuerdo, se pueden determinar directamente los

porcentajes acumulativos. El paso siguiente es decidir lo que se considerará una ratificación (+) en cada reactivo. Generalmente, en un reactivo con las cinco

opciones de respuesta anteriores, marcar ya sea "completamente de acuerdo" o "de acuerdo" se interpretaría como ratificación (+). Marcar cualquiera de las

opciones restantes se consideraría como no ratificación (-) del reactivo. Con reactivos verdaderamente dicotómicos esto es muy sencillo; con reactivos de

opción múltiple no lo es. El punto de corte de un reactivo es el punto dentro de las opciones ordenadas, que separa la ratificación de la no ratificación. En este

ejemplo, el punto de corte está entre "de acuerdo" y "en duda". Hay ocasiones en que se desea trasladar el punto de corte. Esto, obviamente, cambia la proporción

de sujetos que ratifican el reactivo. Al mover el punto de corte hacia abajo, aumenta el porcentaje de ratificación; al moverlo hacia arriba, disminuye.

Existen, básicamente, dos razones para cambiar el punto de corte de un reactivo. Primero, porque puede ser conveniente cambiar la

distribución marginal de los reactivos. Por ejemplo, la distribución podría ser de 20, 30, 60, 80% de ratificación, con el punto de corte entre "de acuerdo" y

"en duda", con respecto a todos los reactivos. Al trasladar el punto de corte al reactivo del 30%, para incluir "en duda" como ratificación, puede convertirse

ese reactivo en uno de 40%. Esta es una distribución marginal, preferible por razones que serán descritas más adelante. Segundo, al trasladar el punto de

corte de un reactivo a veces es posible convertir un reactivo impropio de la escala en uno adecuado. Manteniendo constante, en la medida de lo posible, el punto

de corte de respuesta (por ejemplo, entre las respuestas "de acuerdo" y "en duda" en el grupo de opciones anterior), el investigador debe seleccionar los

reactivos que hagan máxima la distancia entre los reactivos marginales (la proporción de sujetos que ratifican el reactivo). Por ejemplo, una escala de

cuatro reactivos debe contener reactivos marginales de 20, 40, 60 y 80%. Cuanto más separados estén los marginales, tanto menos probable es una inversión del

orden de los reactivos del preexamen al estudio final, o en dos aplicaciones cualesquiera de la escala. Deben evitarse asimismo reactivos con marginales

extremos. Los reactivos necesariamente tienen reproductibilidades iguales a la respuesta modal (ya sea + o -). Esto quiere decir que reactivos con marginales

más grandes del 80% o de menos del 20% pueden infundir excesiva confianza en la factibilidad de hacer una escala del universo de contenido que se esté

considerando. En el conjunto de reactivos de ensayo seleccionado, cada uno de aquéllos debe contrastar con cada uno de los demás para determinar si los

reactivos se ajustan entre sí suficientemente para ser compatibles con el modelo de Guttman. En el caso de una relación perfecta entre dos reactivos, donde uno

es más difícil de ratificar que el otro, todos los sujetos que ratifican el reactivo con el marginal más pequeño (el más difícil) deben ratificar también el

menos difícil.

El grado en que los reactivos satisfacen esta relación

perfecta se refleja en la "celdilla de error" de cada tabla cuádruple (véase figura 1). Ninguna celdilla de error debe contener más del 10% del número total

de sujetos. Y las celdillas de la diagonal principal (+ +) y (- -) de cada tabla deben contener al menos tantos casos como los que se encuentran en la celdilla

de error (Toby y Toby, 1954). El error del reactivo es la proporción de sujetos que ratifican el reactivo más difícil pero que fallan en el reactivo más fácil.

Una vez establecido el punto de corte de cada reactivo y su error, necesitan obtenerse los patrones de respuesta. Esto se logra determinando

las respuestas de cada sujeto en todos los reactivos. La sucesión de observaciones comienza con el reactivo menos frecuentemente ratificado y

continúa con los demás, en orden descendente de dificultad. Si se usa un clasificador de tarjetas y se tratan los reactivos en forma dicotómica, el

primer paso de las tarjetas por la máquina producirá dos grupos de tarjetas: uno representa a los sujetos que ratificaron el reactivo (+) y el otro, a aquéllos

que no lo ratificaron (-).

Cada grupo se corre después al segundo reactivo según su grado de dificultad. Esto puede producir cuatro grupos que representan a

quienes: 1. ratificaron el reactivo más difícil y el siguiente más difícil (+ +); 2. ratificaron el reactivo más difícil pero no el siguiente (+ -); 3. no

ratificaron el primero pero sí el segundo (- +), y 4. no ratificaron ninguno de los dos (- -). Luego, cada uno de estos grupos se corre al reactivo con la

tercera frecuencia más baja de ratificación, lo que podría generar ocho patrones de respuesta: 1. +++, 2. ++-, 3. +-+, 4. +- -, 5. -++, 6. -+-, 7. - -+, y 8. - -

-. E I procedimiento se continúa hasta concluir el examen de todos los reactivos que componen la escala. El número de patrones posibles de respuesta es una

función del número de reactivos.

Con respecto a reactivos dicotómicos, el número de patrones de respuesta posibles es 2n, donde n es igual al número de reactivos. Entonces

una escala de cuatro reactivos puede producir 16 patrones de respuesta (24) y una escala de ocho reactivos, 256 (28). Sin embargo, del número de patrones de

respuesta posibles, solamente n + 1 son tipos perfectos o puros, es decir, patrones de respuesta que indican tal consistencia de respuesta que si se

ratifica un reactivo en determinada posición escalar, todos los reactivos por debajo de él también lo serán. Por ejemplo, en una escala de cuatro reactivos,

los patrones de respuesta ++++, -+++, --++, - - -+ y - - - - son tipos puros. Los otros patrones donde se advierten fallas en presentar consistencia de

respuesta son tipos no escalares o de error. La colocación de los Tipos de

Error Habida cuenta de que, en realidad, la escala perfecta es sólo aproximada, inevitablemente existen algunos patrones de respuesta que no son

tipos aptos para una escala y deben asignarse a patrones de respuesta perfectos o puros. Existen varios métodos para clasificar las respuestas no escalares. El primer criterio que se usa en este procedimiento es

reducir al mínimo el error. En sentido estricto, el sujeto ha cometido error cuando se desvía en su patrón de respuesta del tipo escalar puro. El problema

consiste entonces en colocar su patrón de respuesta en uno de los tipos escalares puros, de manera que su desviación produzca la mínima cantidad de

error. Por ejemplo, usando este criterio, el patrón -+- - (del más al menos difícil, de izquierda a derecha) puede asignarse solamente al tipo escalar 0

(----). Cualquier otra asignación daría dos o más errores. Si fuera colocado en el grupo escalar 1 (-- -+), se admitirían dos errores asociados a los reactivos

2 y 4. Si se colocara en el tipo escalar 2, contendría tres errores que abarcarían los reactivos 2, 3 y 4.

El criterio de error mínimo resolverá el problema de clasificar las respuestas no escalares cuando no sea posible más que una asignación. Sin embargo, hay

patrones que pueden clasificarse en dos o más tipos escalares empleando este criterio. La respuesta +-++ podría considerarse ya sea como el tipo escalar 2

(--++), con un error asociado al primer reactivo, o como el tipo escalar 4 (++++), donde el segundo reactivo explica un error.

En aquellos casos en que el criterio de error mínimo asigna un patrón de respuesta a dos o más tipos escalares, se han desarrollado varias soluciones.

Cuando hay razón para creer en la presencia de error de respuesta sistemático en los reactivos con los marginales más grande y más pequeño, podría emplearse la

técnica del valor medio, la cual confiere mayor valor a los reactivos intermedios. La decisión con respecto a la colocación de respuestas clasificadas

ambiguamente, por el criterio de error mínimo, se determina con las respuestas a los reactivos intermedios. Por ejemplo, el patrón +-++ podría colocarse ya sea

en el tipo escalar 2, o en el 4, con un error. Si se colocara en el tipo escalar 2, el reactivo 1, un reactivo extremo, explicaría el error. La asignación al

tipo escalar 4 colocaría el error en el reactivo 2. Si el análisis de reactivos descrito anteriormente hubiera indicado que el reactivo 1 estaba sujeto a error

considerable, suponer una probabilidad de error más grande en el reactivo 1 que en el 2 quedaría justificado. Por consiguiente, se tomaría la decisión, con base

en la confiabilidad más grande del reactivo 2, de asignar el patrón de respuesta al tipo escalar 2, dándosele así un valor mayor al reactivo intermedio. (Henry,